视频大数据时间kaiyun体育,确实来了!

刚刚,李飞飞的斯坦福团队同谷歌合营,推出了用于生成传神视频的扩散模子W.A.L.T。

这是一个在分享潜在空间中磨砺图像和视频生成的,基于Transformer的扩散模子。 英伟达高等科学家Jim Fan转发指摘说念:2022年是影像之年,2023是声波之年,而2024,是视频之年!

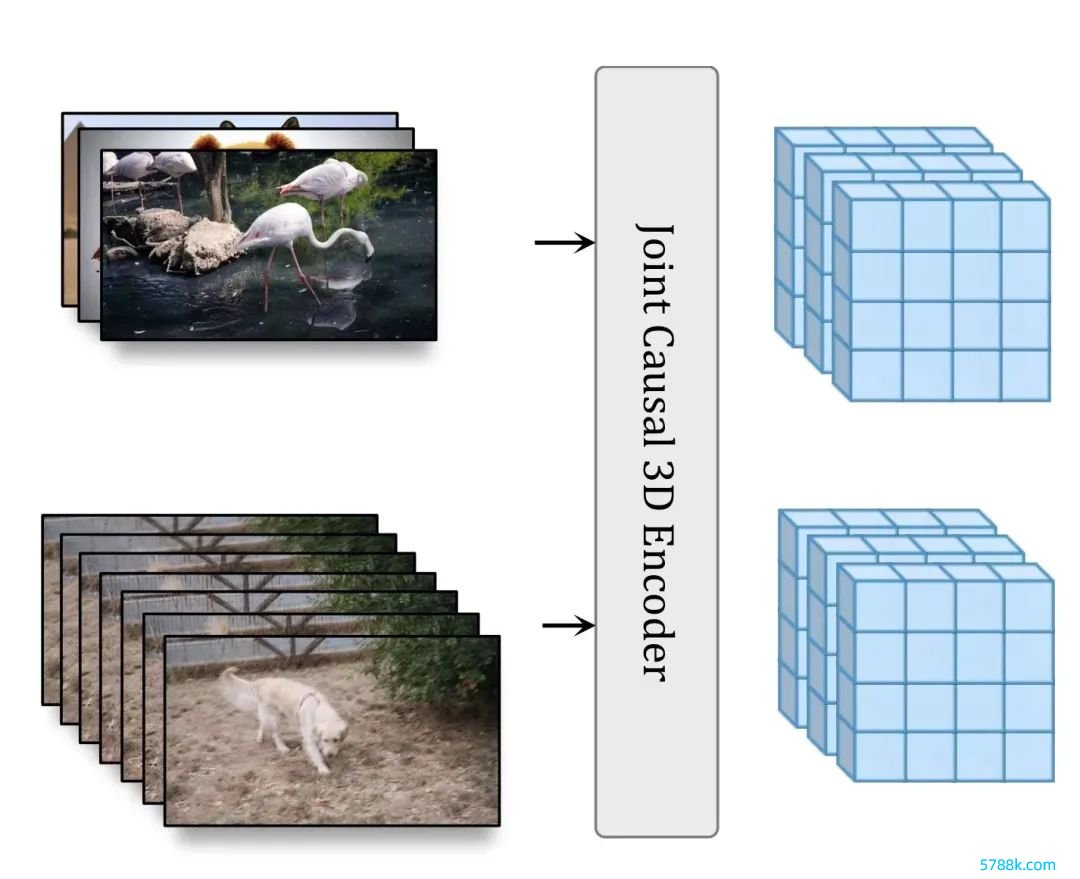

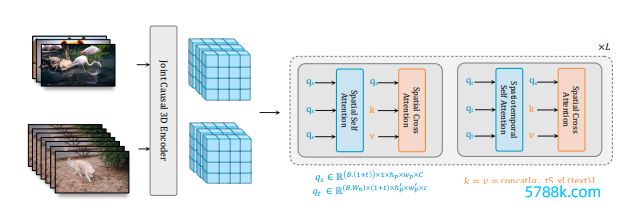

这是一个在分享潜在空间中磨砺图像和视频生成的,基于Transformer的扩散模子。 英伟达高等科学家Jim Fan转发指摘说念:2022年是影像之年,2023是声波之年,而2024,是视频之年!  起先,参谋东说念主员使用因果编码器在分享潜在空间中压缩图像和视频。

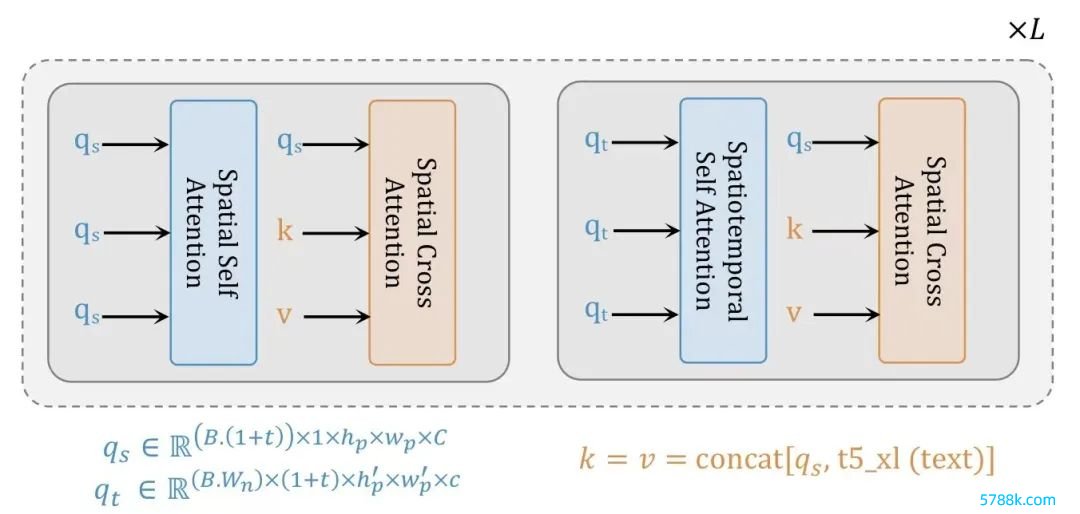

起先,参谋东说念主员使用因果编码器在分享潜在空间中压缩图像和视频。 其次,为了莳植挂牵和磨砺遵守,参谋东说念主员使用基于窗口提防的变压器架构来进行潜在空间中的蚁合空间和期间生成建模。

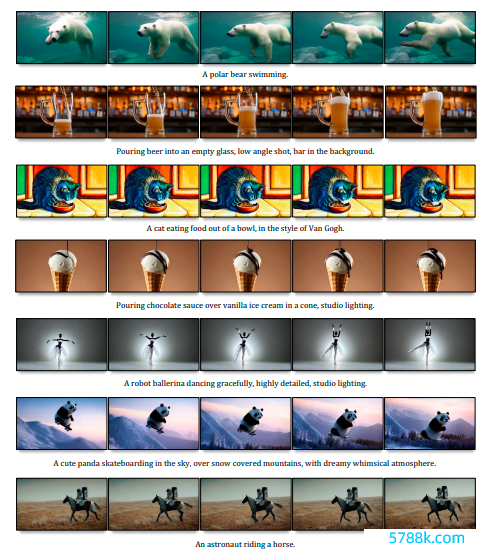

其次,为了莳植挂牵和磨砺遵守,参谋东说念主员使用基于窗口提防的变压器架构来进行潜在空间中的蚁合空间和期间生成建模。  参谋东说念主员的模子不错根据当然话语辅导生成传神的、期间一致的引导:

参谋东说念主员的模子不错根据当然话语辅导生成传神的、期间一致的引导:  A Teddy bear skating carefully in Times Square,Slow Motion/一只泰迪熊在时间广场上优雅的溜冰,慢动作

A Teddy bear skating carefully in Times Square,Slow Motion/一只泰迪熊在时间广场上优雅的溜冰,慢动作  Pouring chocolate sauce over vanilla ice cream in a cone, studio lighting/将巧克力酱倒在香草冰淇淋甜筒上,就业室灯光

Pouring chocolate sauce over vanilla ice cream in a cone, studio lighting/将巧克力酱倒在香草冰淇淋甜筒上,就业室灯光  An stronaust riding a horse/又名宇航员骑着马

An stronaust riding a horse/又名宇航员骑着马  A squirrel eating a burger/一只松鼠在吃汉堡

A squirrel eating a burger/一只松鼠在吃汉堡  A panda taking a selfie/一只正在自拍的熊猫

A panda taking a selfie/一只正在自拍的熊猫  An elephant wearing a birthday hat walking on the beach/一头戴着寿辰帽的大象在海滩上行走

An elephant wearing a birthday hat walking on the beach/一头戴着寿辰帽的大象在海滩上行走  Sea lion admiring nature, river, waterfull, sun, forest/海狮抚玩当然,河流,瀑布,阳光,丛林

Sea lion admiring nature, river, waterfull, sun, forest/海狮抚玩当然,河流,瀑布,阳光,丛林  Pouring latte art into a silver cup with a golden spoon next to it/在银杯中进行拿铁拉花,傍边放着金勺子

Pouring latte art into a silver cup with a golden spoon next to it/在银杯中进行拿铁拉花,傍边放着金勺子  Two knights dueling with lightsabers,cinematic action shot,extremely slow motion/两个骑士用光剑决斗,电影动作镜头,极其慢动作

Two knights dueling with lightsabers,cinematic action shot,extremely slow motion/两个骑士用光剑决斗,电影动作镜头,极其慢动作

A swarm of bees flying around their hive/一群蜜蜂在他们的蜂巢周围遨游

这个结构还不错用图片生成视频:

A giant dragon sitting in a snow covered landscape, breathing fire/一条浩繁的龙盘踞在冰雪秘籍的地面上,喷吐着火焰

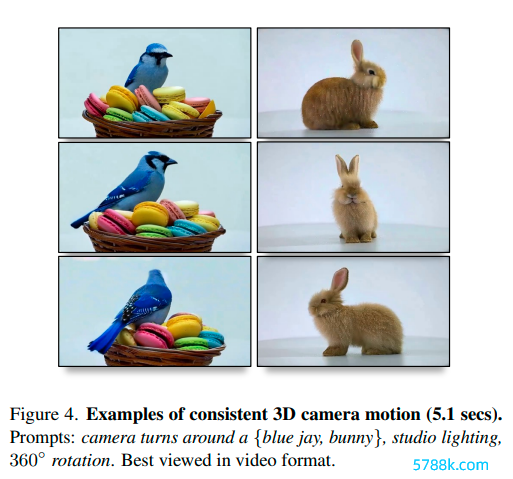

A giant dragon sitting in a snow covered landscape, breathing fire/一条浩繁的龙盘踞在冰雪秘籍的地面上,喷吐着火焰 An asteroid collides with Earth, massive explosive, slow motion/小行星撞上地球,大领域爆炸,慢动作 以及,生成一致性很高的3D相机引导的视频。

An asteroid collides with Earth, massive explosive, slow motion/小行星撞上地球,大领域爆炸,慢动作 以及,生成一致性很高的3D相机引导的视频。  Cameraturns around a cute bunny, studio lighting, 360 rotation/相机围绕一只能人的兔子旋转,就业室灯光,360度旋转网友们咋舌说念,这些天好像仍是东说念主手一个LLM或者图像生成器。

Cameraturns around a cute bunny, studio lighting, 360 rotation/相机围绕一只能人的兔子旋转,就业室灯光,360度旋转网友们咋舌说念,这些天好像仍是东说念主手一个LLM或者图像生成器。  本年险些是AI发展的挑动性的一年。

本年险些是AI发展的挑动性的一年。  两个过失决议 组成三模子级联W.A.L.T的循序有两个过失决议。 起先,参谋者使用因果编码器在调理的潜在空间内蚁合压缩图像和视频,从而收尾跨模态的磨砺和生成。 其次,为了莳植挂牵和磨砺遵守,参谋者使用了为空间和时空蚁合生成建模量身定制的窗口提防力架构。 通过这两个过失决议,团队在已缔造的视频(UCF-101 和 Kinetics-600)和图像(ImageNet)生成基准测试上收尾了SOTA,而无需使用无分类器率领。 终末,团队还磨砺了三个模子的级联,用于文本到视频的生成任务,包括一个基本的潜在视频扩散模子和两个视频超区分率扩散模子,以每秒8帧的速率,生成512 x 896区分率的视频。

两个过失决议 组成三模子级联W.A.L.T的循序有两个过失决议。 起先,参谋者使用因果编码器在调理的潜在空间内蚁合压缩图像和视频,从而收尾跨模态的磨砺和生成。 其次,为了莳植挂牵和磨砺遵守,参谋者使用了为空间和时空蚁合生成建模量身定制的窗口提防力架构。 通过这两个过失决议,团队在已缔造的视频(UCF-101 和 Kinetics-600)和图像(ImageNet)生成基准测试上收尾了SOTA,而无需使用无分类器率领。 终末,团队还磨砺了三个模子的级联,用于文本到视频的生成任务,包括一个基本的潜在视频扩散模子和两个视频超区分率扩散模子,以每秒8帧的速率,生成512 x 896区分率的视频。  W.A.L.T的过失,是将图像和视频编码到一个分享的潜在空间中。 Transformer骨干通过具有两层窗口禁止提防力的块来处理这些潜在空间——空间层捕捉图像和视频中的空间关联,而时空层模拟视频中的期间动态,并通过身份提防力掩码传递图像。 而文本攻击,是通过空间交叉提防完成的。W.A.L.T搞定视频生成建模攻击Transformer是高度可推广和可并行的神经辘集架构,是现在最当红的构架。 这种理思的特点也让参谋界越来越好奇Transformer,而不是话语 、音频、语音、视觉、机器东说念主时期等不同领域的特定领域架构。 这种调理的趋势,使参谋东说念主员巧合分享不同传统帅域的跨越,这么就教训了有意于Transformer的模子蓄意立异和考订的良性轮回。 推敲词,有一个例外,即是视频的生成建模。 扩散模子已成为图像和视频生成建模的起先轨范。推敲词,由一系列卷积层和自提防力层组成的U-Net架构一直是总计视频扩散循序的主流。 这种偏好源于这么一个事实:Transformer中都备提防力机制的挂牵需求,与输入序列的长度呈二次方缩放。 在处理视频等高维信号时,这种缩放会导致本钱过高。

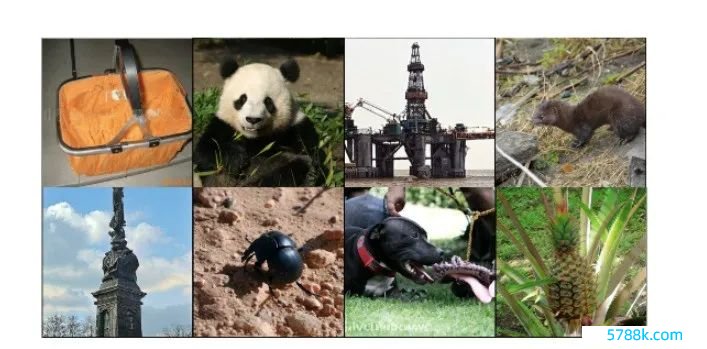

W.A.L.T的过失,是将图像和视频编码到一个分享的潜在空间中。 Transformer骨干通过具有两层窗口禁止提防力的块来处理这些潜在空间——空间层捕捉图像和视频中的空间关联,而时空层模拟视频中的期间动态,并通过身份提防力掩码传递图像。 而文本攻击,是通过空间交叉提防完成的。W.A.L.T搞定视频生成建模攻击Transformer是高度可推广和可并行的神经辘集架构,是现在最当红的构架。 这种理思的特点也让参谋界越来越好奇Transformer,而不是话语 、音频、语音、视觉、机器东说念主时期等不同领域的特定领域架构。 这种调理的趋势,使参谋东说念主员巧合分享不同传统帅域的跨越,这么就教训了有意于Transformer的模子蓄意立异和考订的良性轮回。 推敲词,有一个例外,即是视频的生成建模。 扩散模子已成为图像和视频生成建模的起先轨范。推敲词,由一系列卷积层和自提防力层组成的U-Net架构一直是总计视频扩散循序的主流。 这种偏好源于这么一个事实:Transformer中都备提防力机制的挂牵需求,与输入序列的长度呈二次方缩放。 在处理视频等高维信号时,这种缩放会导致本钱过高。  Figure 5. lmageNet class-conditional generation samples 潜在扩散模子不错通过在从自动编码器派生的低维潜在空间中启动,来缩短筹办要求。 在这种情况下,一个过失的蓄意接受,即是所使用的潜在空间的类型:空间压缩 (每帧潜在) 与时空压缩。 空间压缩往往是首选,因为它不错行使预磨砺的图像自动编码器和LDM,它们在大型成对图像文本数据集上进行磨砺。 推敲词,这种接受增多了辘集复杂性,并禁止了Transformer动作骨干网的使用,尤其是由于内存禁止而生成高区分率视频时。 另一方面,固然时空压缩不错缓解这些问题,但它根除了配对图像文本数据集的使用,后者比视频数据集更大、更各类化。 因此,参谋者提倡了窗口提防力潜在Transformer (W.A.L.T) :一种基于Transformer的潜在视频扩散模子 (LVDM) 循序。 该循序由两个阶段组成。 起先,自动编码器将视频和图像映射到调理的低维潜在空间中。这种蓄意巧合在图像和视频数据集上蚁合磨砺单个生成模子,并权贵减少生成高区分率视频的筹办背负。 随后,参谋者提倡了一种用于潜在视频扩散建模的Transformer块的新蓄意,由在非访佛、窗口禁止的空间和时空提防力之间轮流的自提防力层组成。

Figure 5. lmageNet class-conditional generation samples 潜在扩散模子不错通过在从自动编码器派生的低维潜在空间中启动,来缩短筹办要求。 在这种情况下,一个过失的蓄意接受,即是所使用的潜在空间的类型:空间压缩 (每帧潜在) 与时空压缩。 空间压缩往往是首选,因为它不错行使预磨砺的图像自动编码器和LDM,它们在大型成对图像文本数据集上进行磨砺。 推敲词,这种接受增多了辘集复杂性,并禁止了Transformer动作骨干网的使用,尤其是由于内存禁止而生成高区分率视频时。 另一方面,固然时空压缩不错缓解这些问题,但它根除了配对图像文本数据集的使用,后者比视频数据集更大、更各类化。 因此,参谋者提倡了窗口提防力潜在Transformer (W.A.L.T) :一种基于Transformer的潜在视频扩散模子 (LVDM) 循序。 该循序由两个阶段组成。 起先,自动编码器将视频和图像映射到调理的低维潜在空间中。这种蓄意巧合在图像和视频数据集上蚁合磨砺单个生成模子,并权贵减少生成高区分率视频的筹办背负。 随后,参谋者提倡了一种用于潜在视频扩散建模的Transformer块的新蓄意,由在非访佛、窗口禁止的空间和时空提防力之间轮流的自提防力层组成。

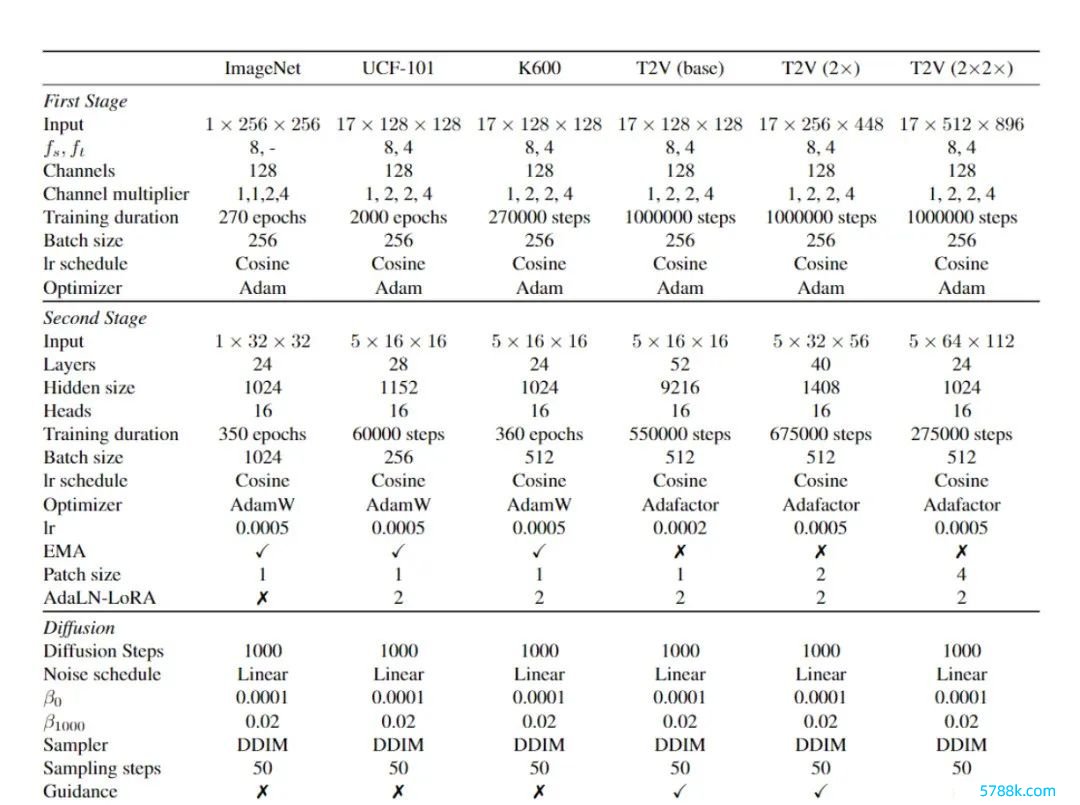

Table 8. Training and evaluation hyperparameters.

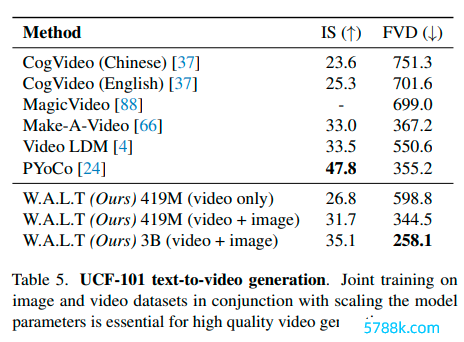

这种蓄意有两个主要平正—— 起先,使用局部窗口提防力,不错权贵缩短筹办需求。 其次,它有意于蚁合磨砺,其中空间层寥寂处理图像和视频帧,而时空层发愤于于对视频中的期间关联进行建模。 固然看法上很浅显,但团队的循序让Transformer在民众基准上潜在视频传播中证据出了不凡的质地和参数遵守,这是第一个教导笔据。 具体来说,在类条件视频生成 (UCF-101) 、帧测度 (Kinetics-600) 和类条件图像生成 (ImageNet)上, 不使用无分类率领,就得到了SOTA。 终末,为了发挥这种循序的可推广性和遵守,参谋者还生成了传神的文本到视频生成驱散。 他们磨砺了由一个基本潜在视频扩散模子和两个视频超区分率扩散模子组成的级联模子,以每秒8帧的速率生成512X896区分率的视频,何况在UCF-101基准测试中,得到了SOTA的zero-shot FVC分数。

学习视觉标记

视频生成建模中的一个过失蓄意决议,即是潜在空间表征的接受。 理思情况下,需要一个分享且调理的压缩视觉表征,可用于图像和视频的生成建模。 调理的表征很蹙迫,这是因为由于标记视频数据(举例文本视频对)的稀缺,蚁合的图像-视频学习更可取。 为了收尾视频和静态图像的调理表征,第一帧永远寥寂于视频的其余部分进行编码。 为了将这个蓄意实例化,参谋者使用了MAGVIT-v2分词器的因果3DCNN编码器-解码器。 往往,编码器-解码器由老例D卷积层组成,它们无法寥寂处理第一帧。而因果3D卷积层搞定了这个问题,因为卷积核仅对往常的kt-1帧进行操作。

这就确保了每个帧的输出仅受前边帧的影响,从而使模子巧合寥寂标记第一帧。

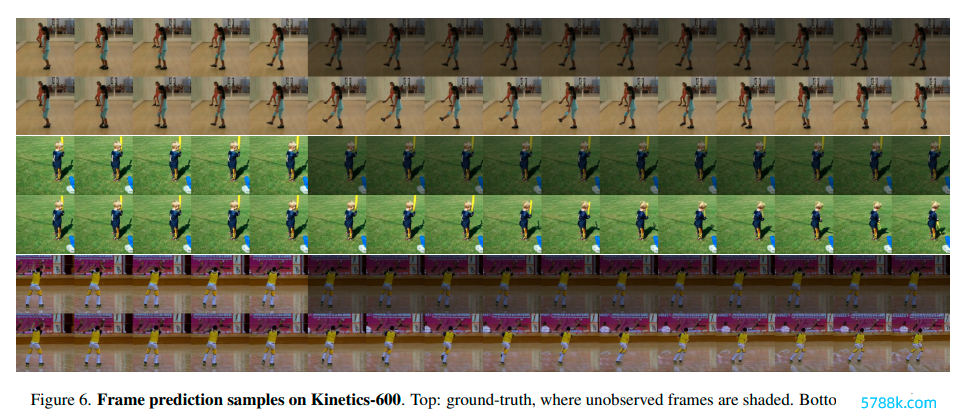

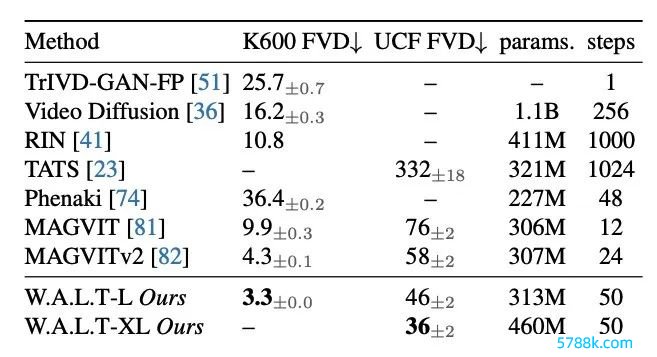

现实视频生成 参谋东说念主员谈判了两个圭臬视频基准,即类别条件生成的UCF-101和带有5个条件帧的视频测度Kinetics-600。 参谋东说念主员使用FVD 动作主要评估主见。在这两个数据集上,W.A.L.T 权贵优于之前的总计就业(下表1)。

现实视频生成 参谋东说念主员谈判了两个圭臬视频基准,即类别条件生成的UCF-101和带有5个条件帧的视频测度Kinetics-600。 参谋东说念主员使用FVD 动作主要评估主见。在这两个数据集上,W.A.L.T 权贵优于之前的总计就业(下表1)。

Table 1. Video generation evaluation on frame prediction on Kinetics-600 and class-conditional generation on UCF-101.

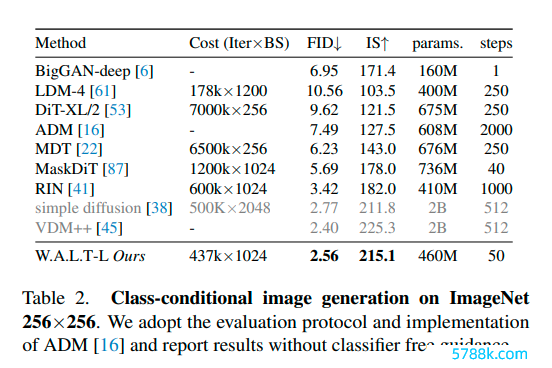

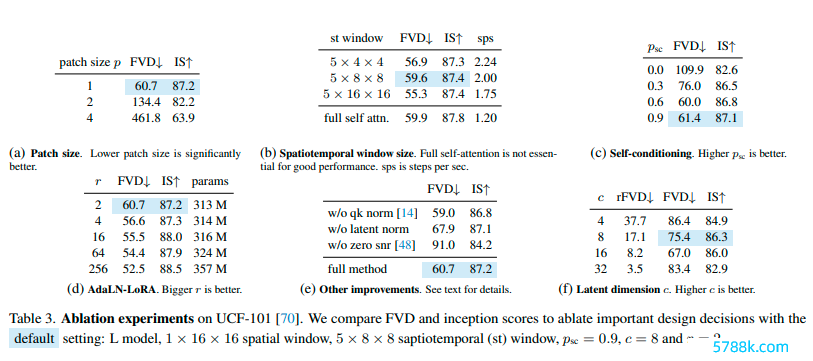

与之前的视频扩散模子比拟,参谋东说念主员在模子参数更少的情况下收尾了起初进的性能,何况需要50个DDIM推理循序。 图像生成 为了考据W.A.L.T在图像领域的建模技艺,参谋东说念主员磨砺了一个W.A.L.T版块,用于圭臬的ImageNet类别条件缔造。 在评估中,参谋东说念主员辞退ADM并禀报在50K样本上用50个DDIM循序生成的FID和Inception分数。 参谋东说念主员将W.A.L.T与256 × 256区分率的起初进图像生成循序进行比较(下表2)。参谋东说念主员的模子在不需要有意的调度、卷积归纳偏见、考订的扩散损构怨无分类器率领的情况下优于之前的就业。尽管VDM++的FID分数略有莳植,但该模子的参数彰着更多(2B)。 消融现实 在使用ViT -based模子的各类筹办机视觉任务中,仍是发挥较小的补丁大小p不错永远莳植性能。相似,参谋东说念主员的参谋驱散也标明,减小补丁大小不错莳植性能(下表3a)。 窗口提防力 参谋东说念主员比较了三种不同的STW窗口设置与全自提防(表3b)。参谋东说念主员发现,局部自提防力不错在速率上权贵更快(高达2倍)何况减少加快器内存的需求,同期达到有竞争力(或更好)的性能。

消融现实 在使用ViT -based模子的各类筹办机视觉任务中,仍是发挥较小的补丁大小p不错永远莳植性能。相似,参谋东说念主员的参谋驱散也标明,减小补丁大小不错莳植性能(下表3a)。 窗口提防力 参谋东说念主员比较了三种不同的STW窗口设置与全自提防(表3b)。参谋东说念主员发现,局部自提防力不错在速率上权贵更快(高达2倍)何况减少加快器内存的需求,同期达到有竞争力(或更好)的性能。

文生视频

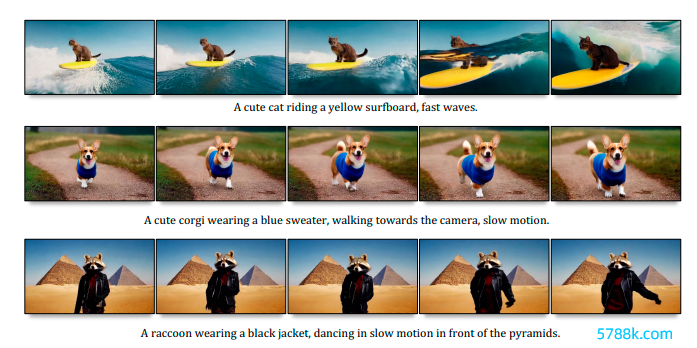

参谋者在文本-图像和文本-视频对上,蚁合磨砺了文本到视频的W.A.L.T。

使用的是来振作家互联网和里面开首的约970M文本-图像对,和约89M文本-视频对的数据集。定性评估

W.A.L.T根据当然话语辅导生成的示例视频,区分率为512*896,捏续期间为3.6秒,每秒8帧。 W.A.L.T模子巧合生成与文本辅导一致、期间一致的传神视频。 参谋东说念主员在以1或2个潜在帧为条件的帧测度任务上,蚁合磨砺了模子。 因此,模子可用于图像动画(图像到视频)和生成具有连贯镜头引导的较长视频。

参谋东说念主员在以1或2个潜在帧为条件的帧测度任务上,蚁合磨砺了模子。 因此,模子可用于图像动画(图像到视频)和生成具有连贯镜头引导的较长视频。

定量评价

科学地评估文本条件视频生成系统仍然是一个要紧挑战,部分原因是枯竭圭臬化的磨砺数据集和基准。 到现在为止,参谋东说念主员的现实和分析主要聚集在圭臬学术基准上,这些基准使用换取的磨砺数据来确保受控和公正的比较。 尽管如斯,为了与之前的文本到视频就业进行比较,参谋东说念主员还在表 5 中的零样本评估左券中禀报了 UCF-101 数据集的驱散。 参谋东说念主员框架的主要上风是它巧合同期在图像和视频数据集上进行磨砺。 在上表5中,参谋东说念主员摈斥了这种蚁合磨砺循序的影响。 具体来说,参谋东说念主员使用第5.2 节中指定的默许缔造磨砺了两个版块的W.A.L.T-L (每个版块有 419M 参数)模子。

参谋东说念主员框架的主要上风是它巧合同期在图像和视频数据集上进行磨砺。 在上表5中,参谋东说念主员摈斥了这种蚁合磨砺循序的影响。 具体来说,参谋东说念主员使用第5.2 节中指定的默许缔造磨砺了两个版块的W.A.L.T-L (每个版块有 419M 参数)模子。参谋东说念主员发现蚁合培训不错使这两个主见都有权贵改善。

著述开首:新智元kaiyun体育,原文标题:《李飞飞谷歌破局之作!用Transformer生成传神视频,下一个Pika来了?》

风险辅导及免责条目 市集有风险,投资需严慎。本文不组成个东说念主投资建议,也未谈判到个别用户特别的投资方向、财务景色或需要。用户应试虑本文中的任何意见、不雅点或论断是否相宜其特定景色。据此投资,就业欣忭。